메모리 풀링과 셰어링 통해 총소유비용(TCO) 절감 기대

[아이티데일리] 최근 대용량 데이터를 필요로 하는 AI 워크로드가 증가하는 추세다. 특히 대규모 클러스터로 구성된 서버의 전체 메모리 풀에서 프로세서(CPU, GPU)로 데이터가 이동하는 과정에서 병목이 발생하는 ‘메모리 벽(Memory Wall)’ 현상도 발생하고 있다. 업계에서는 이를 해결하기 위한 방안 중 하나로 메모리 용량과 대역폭을 확장할 수 있는 ‘CXL(Compute Express Link)’을 주목하고 있다.

CXL은 중앙처리장치(CPU), 그래픽처리장치(GPU), 스토리지 등 각각의 장치들을 효율적으로 연결하는 차세대 인터페이스 기술이자 규격이다. PCIe(Peripheral Component Interconnect Express) 인터페이스를 기반으로 구현되며, 용량 확장 및 공유 기능을 통해 총소유비용(TCO)을 절감할 수 있다.

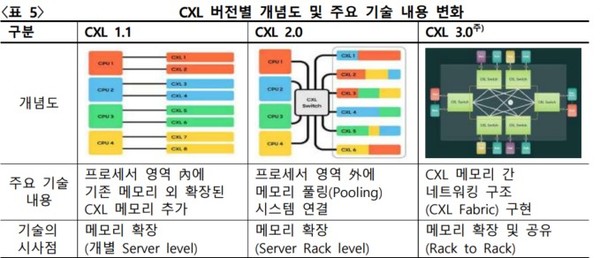

2019년 인텔의 주도 하에 데이터센터, 서버, 프로세서 등 다양한 업체들이 참여해 CXL 컨소시엄을 구성하고, 공동 개발을 시작했다. 해당 컨소시엄에는 삼성전자, SK하이닉스, 엔비디아, 메타 등이 참여하고 있다. CXL 기술 표준은 2019년 1.0 버전을 시작으로 2024년 12월에 3.2 버전까지 공개됐다. 메모리 용량 확장에서 공유 및 보안까지 기술 개념이 확대되고 있다.

왜 CXL을 사용해나 하나?

CXL 기술이 주목받는 이유를 이해하려면 기존 고성능 데이터 전송 기술과의 차이점을 살펴볼 필요가 있다. 비교군으로 RDMA(Remote Direct Memory Access)를 들 수 있다. RDMA는 네트워크 아키텍처인 인피니밴드를 기반으로 한다. RDMA는 CPU와 운영체제를 거치지 않고 네트워크를 통해 효율적으로 서버 간 데이터를 전송할 수 있다.

그러나 CXL과 비교하면 RDMA도 한계점이 있다. RDMA는 서버간 데이터 전송 과정에서 네트워크와 PCIe 변환, 프로토콜 전환 등이 발생한다. 이 같은 데이터 이동 과정은 지연(latency)을 유발하는 원인이 된다. 반면 CXL은 PCIe 기반의 CPU-장치 간 직접 연결을 통해 프로토콜 전환 등 불필요한 중간 과정을 최소화할 수 있다.

풀링과 셰어링 방식으로 활용 가능

CXL의 주요 활용 방식으로 풀링(Pooling)과 셰어링(Sharing)을 꼽을 수 있다. 풀링은 한 마디로 여러 서버가 하나의 메모리 창고를 공유하는 것이다. 각 서버는 필요할 때 원하는 만큼의 메모리를 빠르게 할당받을 수 있다. 기존에는 한 개의 서버에서 메모리가 부족한 경우 느린 디스크로 데이터를 밀어내야 했으나, CXL 풀링을 이용하면 남는 메모리를 다른 서버에서 즉시 빌려 성능 저하를 방지할 수 있다.

셰어링은 여러 서버가 동일한 메모리 공간에 동시에 접근하는 방식이다. 기존에는 같은 데이터를 각 서버마다 중복 저장해야 했다. CXL 셰어링을 통해서는 한 서버에 데이터를 저장하면 나머지 서버들과 공유가 가능해 저장 공간을 절약할 수 있다.

실험으로 CXL 효과성 입증

SK하이닉스는 실제 AI 추론 환경에서 CXL 메모리의 효과를 입증하기 위해 대규모 언어 모델(LLM)인 ‘라마3(Llama 3)’을 활용한 실험을 진행했다. SK하이닉스 김민성 공학박사에 따르면 기존에는 서버에 장착된 D램(DRAM)만으로 AI 모델을 구동할 경우 스레드(thread) 수가 늘어날수록 사용가능한 메모리 대역폭이 부족해져 성능이 떨어지는 것으로 나타났다. 스레드란 CPU와 같은 프로세서에서 작업을 처리하는 단위를 가리킨다.

반면 CXL 메모리 모듈을 추가로 장착한 결과, 메모리 대역폭이 크게 확장되면서 더 많은 스레드를 활용해도 성능이 꾸준히 향상되는 것으로 파악됐다. 김민성 박사는 “D램만 사용할 때는 16스레드 이후 성능이 정체됐지만, CXL 메모리를 병행하자 32스레드까지도 성능이 지속적으로 증가했다”며 “이 실험을 통해 CXL 메모리가 AI 인퍼런스(추론)와 같이 대용량 데이터와 높은 메모리 대역폭이 요구되는 환경에서 서버의 처리 성능을 높일 수 있음을 확인했다”고 설명했다.

SK하이닉스, 삼성전자 CXL 관련 제품 선봬

SK하이닉스는 지난 4월 23일 CXL 2.0 버전 기반 ‘CXL 메모리모듈(CMM)-DDR5’ 96기가바이트(GB) 제품의 고객 인증을 완료했다고 밝혔다. 회사는 데이터센터를 구축·운영하는 고객을 대상으로 총소유비용(TCO)을 절감할 수 있다고 설명했다.

더불어 SK하이닉스는 CXL D램에 최적화된 소프트웨어인 ‘HMSDK((Heterogeneous Memory S/W Development Kit)’를 자체 개발했다. HMSDK는 D램 모듈과 CMM-DDR5 간의 효율적인 교차 배열을 통해 대역폭을 넓힐 수 있으며, 데이터 사용 빈도에 따라 적합한 메모리 장치로 데이터를 재배치할 수 있다.

삼성전자 또한 2021년 5월 ‘CMM-D’ 개발을 발표한 후, 2022년 5월 ‘CMM-D 2.0’을 공개했다. 해당 제품은 512GB 메모리 모듈에 고대역폭을 지원하며, 지연 시간을 줄이는 목표로 설계됐다. 특히 회사는 CMM-D를 기존 서버 시스템에 적용하면 메모리 용량을 최대 50% 개선할 수 있다고 강조했다.