데이터 이동 최소화로 AI 성능·효율 강화

[아이티데일리] 인공지능 응용 서비스(클라우드 AI, 피지컬 AI 등) 활용이 증가함에 따라 데이터 전송량 역시 급격히 늘어나는 추세다. 이에 메모리에서 주요 프로세서(CPU, GPU)로 데이터를 옮기는 과정에서 병목이 발생하는 ‘메모리 벽(Memory Wall)’ 현상이 두드러지고 있다.

AI 반도체 시장에서는 대역폭(BandWith), 용량, 에너지 효율성에 대한 확장성이 요구되며, 다양한 메모리 포트폴리오를 통한 메모리 벽 극복이 주요 과제로 떠오르고 있다. 이런 상황에서 주목받는 방안 중 하나가 ‘프로세싱 인 메모리(PIM)’다.

PIM은 메모리 내부에 연산장치를 탑재해 데이터를 메모리에서 처리하는 최신 컴퓨팅 기술이다. SK하이닉스 강욱성 부사장의 표현을 빌리면 ‘모든 걸 안에서 소화한다’고 요약할 수 있다. 연산기가 메모리 내부에 위치해 데이터 이동 거리가 극단적으로 줄고, 이를 통해 내부 대역폭(Bandwith)이 향상되며 시스템 에너지와 전력 소모를 절감할 수 있다.

NDP·PIM·ACiM으로 구분

PIM의 종류는 크게 근접 메모리(NDP 타입), 메모리 내부(PIM 타입, ACiM 타입) 연산 처리 형태로 구분할 수 있다. 먼저 NDP 타입의 경우 연산 유닛을 메모리 칩 내부가 아니라 메모리 모듈이나 컨트롤러 근처에 배치해, 데이터를 메모리에서 가까운 위치에서 처리하는 형태다. 메모리 셀 내부에서 직접 연산하지는 않지만, 중앙처리장치(CPU)나 그래픽처리장치(GPU) 등 메인 프로세서와 비교해 데이터 이동 거리가 짧다는 이점이 있다. 다만 최종적인 PIM의 형태가 아닌 바로 이전 단계 수준의 기술로 구분할 수 있다.

다음으로 PIM 타입은 메모리 영역 내에 연산장치가 배치돼 연산장치와 메모리 간 물리적 거리가 극적으로 축소된다. 현재 메모리 제조사들은 PIM 타입을 중심으로 관련 제품들을 개발하고 있다.

ACiM 타입은 메모리 셀 자체에 아날로그 연산 기능이 내장된 구조를 가리킨다. 데이터 저장과 연산이 하나의 메모리 셀 내에서 동시에 이뤄지는 것이다. 현재 한국과학기술원(KAIST) 등 일부 연구기관에서 연구가 진행되는 단계다. 이와 관련해 한국전자기술연구원 최규현 책임연구원은 “ACiM의 경우 대량 양산이나 실제 제품화까지는 기술적 성숙도가 더 필요한 상황”이라고 설명했다.

“엣지 영역에서 먼저 활용 확대될 것”

현재 메모리 제조사들은 PIM을 중심으로 관련 제품들을 개발하고 있다. 먼저 SK하이닉스는 지난 2022년 ‘GDDR6-AiM’ 제품을 개발했으며, 2023년 상반기 제품들로 구성된 AiMX AI 가속기카드 시제품을 공개했다. AiM(Accelerator-in-Memory)은 SK하이닉스의 PIM 반도체 상품명이며, AiMX는 GDDR6-AiM 칩을 활용해 대규모언어모델(LLM)에 특화된 가속기 카드다.

SK하이닉스 차세대 상품기획 담당 강욱성 부사장은 “SK하이닉스는 PIM 기술로 데이터센터 시장을 겨냥하고 있으며, 현재 개념검증(PoC) 단계를 진행하고 있다”고 말했다. 이어 그는 “단기적으로는 클라우드보다 엣지 영역에서 먼저 활용될 것으로 본다. 클라우드 분야에는 이미 엔비디아 H100이 자리하고 있고, 모바일 기기의 경우 메모리 확장이 제한적이어서 적용에 한계가 있기 때문이다”라고 설명했다.

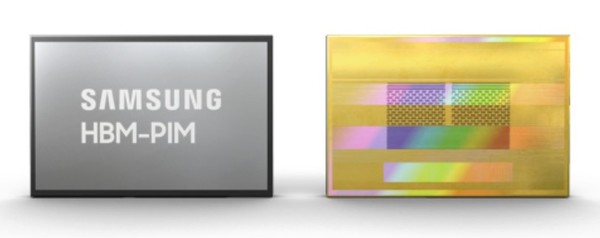

삼성전자는 지난 2021년 ‘HBM-PIM’을 개발했다. 이는 PIM 기술을 활용해 삼성전자가 양산한 2세대 고대역폭 메모리 반도체인 ‘HBM2’에 인공지능 엔진을 탑재한 것이다. 삼성전자에 따르면 AI 시스템에 HBM-PIM을 탑재할 때 기존 HBM2를 활용한 시스템과 비교해 성능이 약 2배 이상 높아지는 것으로 파악됐다. 시스템 에너지의 경우 70% 이상 감소한다고 강조했다.

지난 2023년에는 AMD의 GPU ‘MI-100’ 가속기 카드에 HBM-PIM 메모리를 탑재한 바 있다. 삼성전자는 대규모 AI 및 고성능컴퓨팅(HPC) 애플리케이션에 HBM-PIM 클러스터를 적용하자 기존 GPU 대비 성능이 2배 증가하고, 에너지 소모는 50% 절감한 것으로 나타났다고 밝혔다.