기업 데이터 전략의 포스트 스탠다드

[아이티데일리] 데이터의 중요성이 높아지고 새로운 기술이 등장하는 속도가 점점 더 빨라지면서 데이터 관리에 어려움을 겪는 기업은 늘어만 가고 있다. 한때 데이터 레이크는 많고 복잡한 데이터 저장소들을 통합 관리해 대부분의 어려움을 해결해줄 수 있을 것으로 보였지만, 특유의 한계에 의해 기업에서 선택할 수 있는 새로운 선택지가 됐을 뿐 기존의 데이터 아키텍처들을 대체하는 새로운 표준(post standard)를 세우지는 못했다.

오늘날 전 세계의 많은 기업들은 자사의 비즈니스 변화에 맞춰 데이터 전략을 새롭게 수립하고 있다. 차세대 데이터 전략을 수립하려는 기업들이 가장 주목해야 할 것은 데이터 가상화(data virtuarization) 기술이다. 이는 데이터 웨어하우스로 대표되는 기존 데이터 저장소들의 한계와 데이터 레이크의 실패를 극복하기 위해 가장 효과적인 수단으로 보인다.

① 데이터 사일로 가속화하는 클라우드와 MSA

② 차세대 전략의 핵심은 데이터 소스의 논리적인 연결

복잡해지기만 하는 데이터 관리

최근 글로벌 컨설팅 기업 맥킨지가 공개한 보고서에 따르면, 글로벌 상위 2,000개 기업 중 70% 이상이 최근 2년 사이에 최신 기술을 활용한 새로운 데이터 아키텍처를 도입했거나 가까운 시일 내에 도입하려는 로드맵을 가지고 있는 것으로 나타났다. 하지만 이들 중 약 50%는 한 가지로 통합되지 않은 데이터 모델을 활용하고 있으며, 대다수는 자사의 데이터 중 25% 이하만을 단일한 데이터 플랫폼에 통합하고 있는 것으로 나타났다. 이는 기업이 보유한 데이터 중 75% 이상은 통합되지 않은 개별 데이터 저장소에 보관되고 있으며, 데이터 사일로(silo)화가 상당한 수준으로 일어나고 있다는 것을 의미한다.

특히 대다수 기업들이 채택하고 있는 하이브리드, 혹은 멀티 클라우드 환경은 데이터 사일로화를 더욱 가속화시키고 있다. 기업들은 비즈니스 변화에 따른 IT 인프라의 유연성, 탄력성, 가용성 등을 확보하기 위해 하이브리드 및 멀티 클라우드 환경을 사용하고 있다. 그러나 하이브리드 및 멀티 클라우드 환경에서는 전사 데이터들을 통합해 분석하고 활용할 수 있는 집약적인 데이터 기반 서비스를 구축하기 어렵다. 데이터가 저장되는 공간이 다양하게 분산되는 만큼 데이터 라이프 사이클 전반에 대한 관리 비용과 보안 문제는 크게 증가한다.

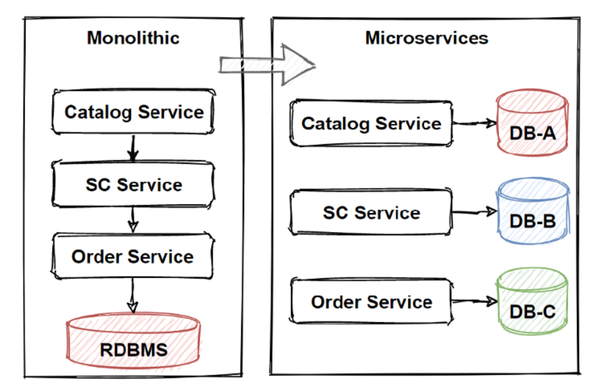

MSA(Micro Service Architecture) 역시 마찬가지다. MSA는 개별 서비스들을 작은 단위로 나누어 운영하면서 기존의 모놀리식 아키텍처(Monolithic Architecture)가 가진 많은 한계들을 극복할 수 있었지만, 반대로 데이터 관리 측면에서는 복잡성을 상당히 높이는 결과를 가지고 왔다. 한발 앞서 SOA(Service-Oriented Architecture)가 그러했던 것처럼 MSA 역시 서비스를 중심으로 IT 인프라를 구성하고 운영하며, 이는 데이터 또한 마찬가지다. MSA를 활용하는 기업에서 데이터 아키텍트는 개별 서비스에 맞춰 데이터 저장소를 나누어 관리해야 하며, 동시에 데이터의 중복 저장을 최대한 방지해 비용효율화를 달성하고 서로 다른 저장소 간의 데이터 정합성을 유지할 수 있어야 한다. 여러 개의 서비스들이 하나의 비즈니스 트랜잭션으로 엮여있을 경우, 데이터 정합성 유지 등은 더욱 큰 과제로 자리잡는다.

데이터는 오래전부터 올바른 비즈니스 의사결정을 내리는 데에 핵심 요소로 인식돼왔고, 최근 몇 년 사이에는 기업의 경쟁력을 확보하기 위해서는 가장 중요하게 관리돼야 할 자원으로 자리잡았다. 그럼에도 불구하고 증가하는 데이터들의 수집과 보관, 무질서한 데이터에 대한 정제와 관리, 분산된 데이터 저장소 간의 중복 및 사일로화 제거 등, 데이터 관리의 가장 가장 기본적인 문제조차도 여전히 기업들의 골칫거리로 남아있다.

데이터 레이크의 두 가지 실패

이러한 골칫거리를 해소할 수 있는 수단으로 가장 먼저 각광받은 것은 데이터 레이크(data lake)였다. 데이터 레이크는 기업이 수집할 수 있는 모든 데이터들을 날것(raw data) 그대로 몰아넣고 관리할 수 있으므로, 폭발적으로 늘어나는 데이터들을 빠르게 저장하면서도 데이터 분석 및 활용에 대한 수요 증가에도 효과적으로 대응 가능할 것으로 예상됐다. 특히 기존의 데이터 웨어하우스(DW)가 구축 단계에서 설정된 형식의 데이터만을 저장할 수 있고 유연성도 떨어져, 데이터 중심 비즈니스에서 새로운 데이터들을 수집하고 활용하는 데에 한계를 드러내고 있었기에 데이터 레이크의 가능성은 더욱 달콤한 과실로 다가왔다.

이에 따라 몇 년 전부터 방대한 데이터를 저장하고 활용하려는 기업들 사이에서 데이터 레이크의 유행이 들불처럼 번져나갔다. 하지만 최근 기업들은 데이터 레이크가 기존의 문제들을 모두 해결해줄 수 있는 만능열쇠가 아님을 깨닫고 있다. 데이터 레이크가 가진 한계가 서서히 수면 위로 떠오르고 있는 셈이다.

데이터 레이크의 실패는 크게 두 가지로 나타났다. 먼저 ROI 측면에서의 실패다. 데이터 레이크를 구축하는 데에 큰 비용을 투자했음에도 불구하고 그 이상의 가치나 인사이트를 얻지 못했기 때문이다. 기존 서비스들을 지속적으로 운영하기 위해 기존 데이터 관련 인프라들을 유지하면서, 이를 통합하고 활용하기 위해 데이터 레이크를 추가적으로 구축하려다보니 데이터 관리나 인프라에 투자되는 비용은 몇 배로 증가했다. 이러한 투자에도 불구하고 전 세계 데이터 레이크 중 상당수는 그저 데이터를 모아서 쌓아두었을 뿐인 데이터 야적장, 혹은 데이터를 한 번 빠트리면 다시 건져 올리기 어려운 데이터 늪(swamp)으로 전락하고 말았다.

많은 이들이 데이터 레이크를 통해 전사 데이터의 사일로화를 해결하고 접근성을 높일 수 있을 것이라고 선전하지만, 정작 데이터 레이크에서 직접 원하는 데이터를 찾는 것은 일부의 데이터 전문가들에게나 가능한 일이다. 조직원들의 데이터 활용 능력을 의미하는 데이터 리터러시(Data Literacy) 관점에서 본다면, 대다수 데이터 레이크들은 전사적인 데이터 리터러시 역량에 부정적인 영향을 미치고 있다.

또 하나의 실패는 데이터 보안 측면에서 나타났다. 기존 데이터베이스(DB)나 DW들은 거의 대부분 관계형DB(RDB) 형태였고, 이에 따라 암호화나 접근 제어, 비식별화 등 대다수 데이터 보안 기술 역시 RDB에 맞춰서 개발됐다. 데이터 저장소가 서로 분리돼 있었기 때문에 개별 저장소마다 서로 다른 보안 기술과 프로세스를 적용함으로써 효과적인 데이터 보안 관리도 가능했다.

하지만 데이터 레이크는 기업 내 모든 데이터들을 하나의 저장소에 집어넣으며, 서로 다른 서비스에서 생산된 데이터들을 결합하고 활용할 수 있어야 하기 때문에 개별 데이터에 대한 암호화나 접근 제어 등을 그대로 적용하기 어렵다. 가령 각각 암호화가 돼있는 A 시스템과 B 시스템의 데이터를 하나의 데이터 레이크에 부어넣었다면, 사용자가 이들을 결합하기 위해서 먼저 각각의 데이터에 적용된 암호화를 자유롭게 해제(복호화)할 수 있어야 한다. 그러나 이같은 자유로운 복호화는 민감정보 관리 측면에서 상당한 문제를 야기할 수 있다. 최근에는 데이터 레이크 상에서도 높은 수준의 데이터 보안을 유지할 수 있도록 다양한 기술들이 개발되고 있지만, 기존에 RDB 기반으로 고도화돼왔던 데이터 보안 기술들에 비하면 크게 부족한 상황이다.